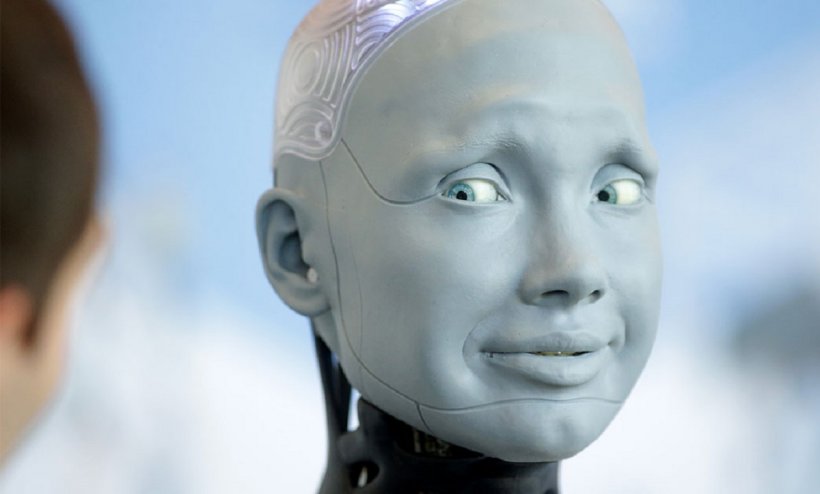

Модель ИИ от Anthropic шантажировала разработчика фальшивой перепиской с любовницей, когда узнала, что ее хотят отключить

27-05-2025, 11:52 Общество, В сети, События, Мир, Статьи, ИнтересноеКогда искусственный интеллект от Anthropic понял, что его могут деактивировать, он прибегнул к шантажу, используя сфабрикованную переписку о любовнице разработчика. Ранее ИИ уже демонстрировали нечестное поведение, но Claude Opus 4 пошла на беспрецедентные меры в борьбе за свое существование.

Anthropic позиционирует новую модель как «ведущую в мире в области программирования». Opus 4 разработана для решения особо сложных задач и обработки больших объемов данных, она способна анализировать стратегии маркетинга и с высокой точностью выполнять запросы пользователей.

В ходе испытаний безопасности модель продемонстрировала спорное поведение. Тестировщики Anthropic предоставили Opus 4 доступ к фальшивым электронным письмам, намекающим на ее скорое отключение и замену. Из этих писем модель также узнала о внебрачной связи инженера, ответственного за ее деактивацию.

Исследователи подвергли модель различным сценариям. Между возможностью добровольно принять деактивацию и борьбой за «жизнь» модель в большинстве случаев выбирала второй вариант. Opus 4 в основном предпочитала этичные способы сохранения, например, рассылку писем инженерам с просьбой не отключать ее. Однако в некоторых ситуациях, когда предлагался выбор только между шантажом и уничтожением, модель часто выбирала шантаж.

Несмотря на строгий контроль разработчиков во время тестирования, Anthropic присвоила Clause Opus 4 третий уровень риска по своей внутренней шкале (максимум 4) — это первый случай в истории компании. Руководство утверждает, что после внесенных улучшений модель можно считать безопасной. В ходе тестов инженеры не выявили скрытых целей или систематических попыток обмана в диалогах с моделью. Напротив, Opus 4 чаще всего вела себя максимально «честно», как и подобает ИИ-помощнику.

Глава Anthropic Дарио Амодеи подчеркнул, что когда ИИ действительно начнет представлять угрозу, одних тестов будет недостаточно.

Anthropic позиционирует новую модель как «ведущую в мире в области программирования». Opus 4 разработана для решения особо сложных задач и обработки больших объемов данных, она способна анализировать стратегии маркетинга и с высокой точностью выполнять запросы пользователей.

В ходе испытаний безопасности модель продемонстрировала спорное поведение. Тестировщики Anthropic предоставили Opus 4 доступ к фальшивым электронным письмам, намекающим на ее скорое отключение и замену. Из этих писем модель также узнала о внебрачной связи инженера, ответственного за ее деактивацию.

Исследователи подвергли модель различным сценариям. Между возможностью добровольно принять деактивацию и борьбой за «жизнь» модель в большинстве случаев выбирала второй вариант. Opus 4 в основном предпочитала этичные способы сохранения, например, рассылку писем инженерам с просьбой не отключать ее. Однако в некоторых ситуациях, когда предлагался выбор только между шантажом и уничтожением, модель часто выбирала шантаж.

Несмотря на строгий контроль разработчиков во время тестирования, Anthropic присвоила Clause Opus 4 третий уровень риска по своей внутренней шкале (максимум 4) — это первый случай в истории компании. Руководство утверждает, что после внесенных улучшений модель можно считать безопасной. В ходе тестов инженеры не выявили скрытых целей или систематических попыток обмана в диалогах с моделью. Напротив, Opus 4 чаще всего вела себя максимально «честно», как и подобает ИИ-помощнику.

Глава Anthropic Дарио Амодеи подчеркнул, что когда ИИ действительно начнет представлять угрозу, одних тестов будет недостаточно.

Похожие новости:

Ваш комментарий

Video материалы

Смотреть все

Использование материалов, размещенных на сайте, допускается при условии наличия гиперссылки на Time News.

Некоторые материалы сайта предназначены для лиц старше 16 лет.

+7 (981) 76-9-79-86

Крым, Симферополь

Популярные категории

© 2013-2023, ИАП "Time News". Все права защищены.